Текст: ГодЛитературы.РФ

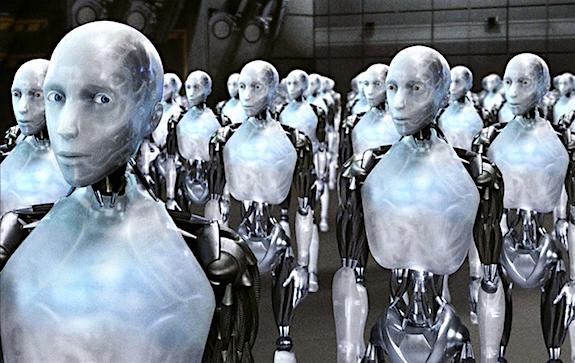

Фото: кадр из фильма «Я, робот», 2004

Одна из основных трудностей, с которой сталкиваются ученые, работающие над созданием искусственного интеллекта, заключается в привитии роботам человеческих ценностей, таких как нормы морали, правила поведения в обществе, способность отличать добро от зла.

Исследователи из Технологического института в Атланте (США) Марк Ридл и Брент Харрисон опубликовали статью, в которой изложили механизмы влияния книг на обучение роботов нормам человеческого поведения. Ученые высказали гипотезу, согласно которой компьютер, обработавший достаточное количество литературных текстов и разобравшийся с зашифрованными в них социокультурными кодами, может, опираясь на эти знания, «поступать правильно».

Методика Ридла и Харрисона была названа «выравнивание ценностей» (value alignment). Ученые уверены, что ключ к определению этих ценностей как раз заключен в литературных произведениях. Согласно статье, сначала книги должны сформировать у роботов понимание обо всех возможных вариантах поведения. А после того, как база действий будет наработана, машины смогут самостоятельно выбирать то поведение, которое будет желательно и безопасно для человека.

Полный текст исследования (на английском) можно найти по ссылке.

Ссылки по теме:

Роботов в Перми программируют по Азимову — ГодЛитературы.РФ, 02.11.2015

Есть ли жизнь на Марсе? — ГодЛитературы.РФ, 03.04.2015